服務(wù)熱線

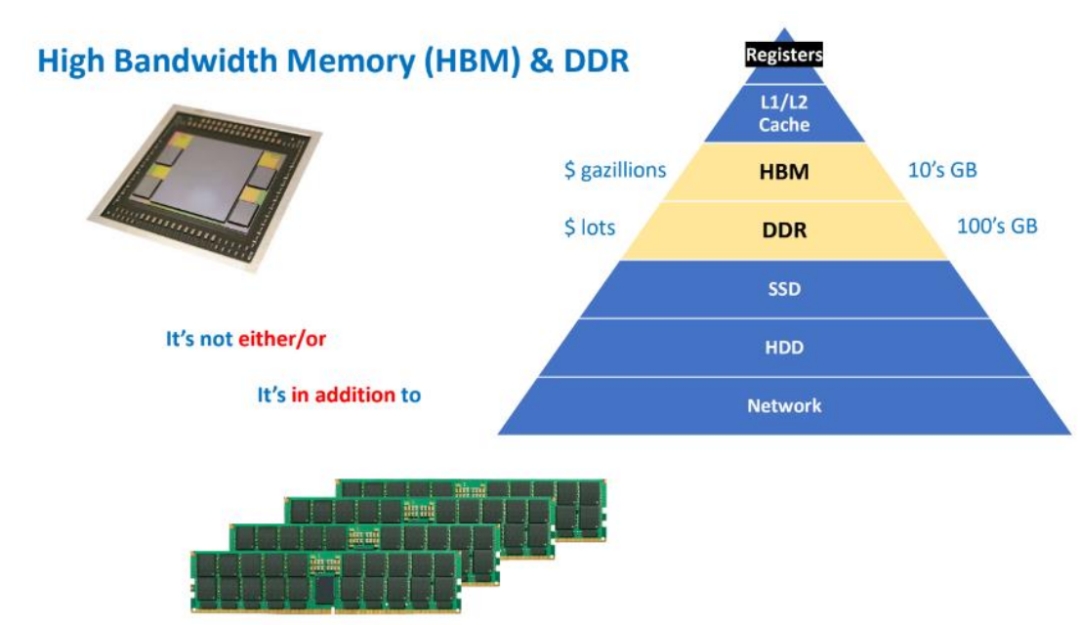

一、引言:AI時(shí)代的“內(nèi)存革命”

在生成式AI、超算和高性能GPU的浪潮中,有一種看似低調(diào)卻決定算力上限的關(guān)鍵部件——HBM(High Bandwidth Memory,高帶寬內(nèi)存)。

如果把GPU比作一臺(tái)擁有數(shù)萬(wàn)氣缸的超高性能引擎,那么HBM就是為它提供燃料的“供油系統(tǒng)”。

油供不上,再好的引擎也只能空轉(zhuǎn)。HBM的使命,就是讓數(shù)據(jù)以“洪流”的速度流入GPU核心,而不是被“滴灌”。

二、HBM是什么:不是“芯片”,而是“系統(tǒng)級(jí)接口標(biāo)準(zhǔn)”

許多人以為HBM是一種新的內(nèi)存芯片,其實(shí)更準(zhǔn)確地說(shuō),HBM是一種定義了“如何讓DRAM以極高帶寬互連”的接口與封裝技術(shù)規(guī)范。

它不是在單顆芯片上堆性能,而是在“堆疊”和“互連”上下功夫。

一個(gè)完整的HBM模塊通常由:

多層垂直堆疊的 DRAM芯片(Die)(4層、8層、甚至12層); 內(nèi)部貫穿每一層的 TSV(Through-Silicon Via,硅通孔); 以及連接GPU與HBM的 中介層(Interposer) 共同組成。

HBM的核心思路是:讓數(shù)據(jù)在最短路徑內(nèi)穿越最多的并行通道。

傳統(tǒng)GDDR的思路是“跑得快”(高頻),HBM的思路是“路更多”(寬位寬)。結(jié)果是:單位時(shí)間傳輸量呈數(shù)量級(jí)提升。

三、GPU與HBM的關(guān)系:算力與供給的“饑餓游戲”

1. GPU的“胃口”

GPU(圖形處理器)天生是“并行怪獸”。

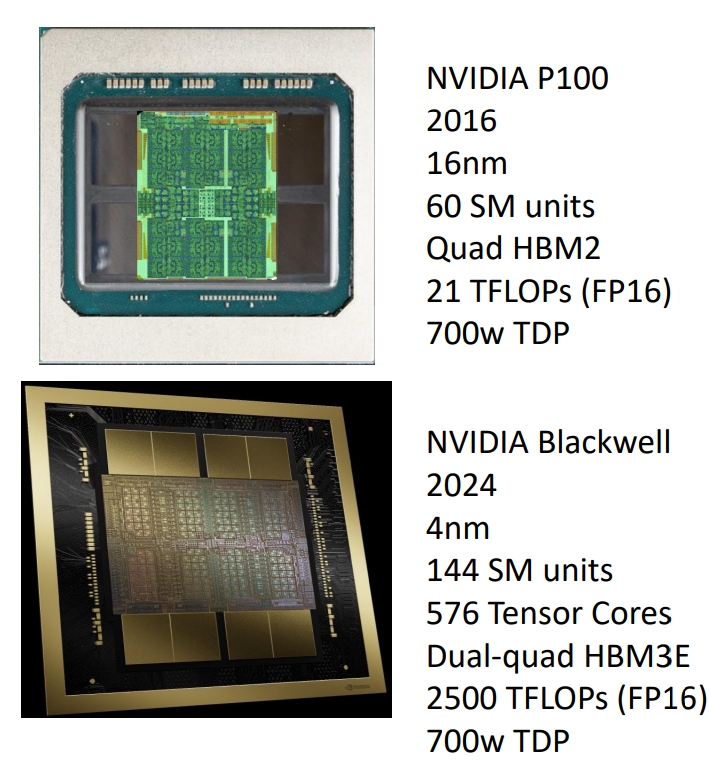

一顆如NVIDIA H100的GPU擁有18,432個(gè)CUDA核心,相當(dāng)于上萬(wàn)個(gè)小計(jì)算單元同時(shí)吃數(shù)據(jù)。

但問(wèn)題是,這些核心吃得太快。如果內(nèi)存送數(shù)據(jù)的速度跟不上,GPU就會(huì)“餓著”——

這就是所謂的內(nèi)存瓶頸(Memory Bottleneck)。

2. 帶寬的定義與瓶頸

內(nèi)存帶寬(Memory Bandwidth)表示單位時(shí)間內(nèi)內(nèi)存可傳輸?shù)臄?shù)據(jù)量。

計(jì)算公式:

帶寬(GB/s) = [總線位寬(bit) × 有效傳輸速率(GT/s)] ÷ 8

HBM的革命性突破在于:

位寬極寬

:每堆HBM的總線可達(dá)1024位甚至2048位; 傳輸頻率高

:每秒傳輸速率可達(dá)6.4GT/s以上; 距離極短、損耗極低

:得益于中介層互連。

結(jié)果就是:

HBM3E帶寬 ≈ 1.2 TB/s

GDDR6帶寬 ≈ 0.064 TB/s

也就是說(shuō),HBM的“供料速度”是GDDR的近20倍。

3. 為什么AI必須用HBM?

AI訓(xùn)練和推理(尤其是大型語(yǔ)言模型、圖像生成模型)涉及數(shù)百GB到數(shù)TB的數(shù)據(jù)流。

這些數(shù)據(jù)要在GPU與內(nèi)存之間不停來(lái)回傳遞:

參數(shù) → 激活值 → 梯度 → 更新。

如果帶寬不夠,GPU核心就像賽車堵在加油站門口——算力再?gòu)?qiáng)也沒(méi)法發(fā)揮。

HBM的高帶寬和低延遲正是為了解決這種“算力饑餓”。

四、HBM的結(jié)構(gòu):從“平面走線”到“垂直通道”

1. 3D堆疊(Stack)

傳統(tǒng)DRAM是平鋪在PCB上的,而HBM將多顆DRAM芯片垂直堆疊,通過(guò)微凸塊(Microbump)層層互連。

這就像把存儲(chǔ)單元從“平面社區(qū)”變成“摩天大樓”,在相同面積下,容量和通道密度成倍增加。

2. 硅通孔(TSV)

每一層DRAM芯片內(nèi)部鉆出直徑僅5-10微米的通孔,填入銅或鎢等導(dǎo)電材料。

這些通孔就是信號(hào)、電源、地線的垂直“電梯井”。

它們實(shí)現(xiàn):

最短互連路徑(僅50~100微米);

最高互連密度(數(shù)萬(wàn)通道);

最低信號(hào)延遲與功耗。

換句話說(shuō),TSV讓“樓層之間的數(shù)據(jù)”以幾乎無(wú)延遲的方式直達(dá)。

這就是HBM得以實(shí)現(xiàn)“超寬總線位寬”的硬件根基。

3. 中介層(Interposer)

GPU與HBM堆棧并不是直接焊在PCB上,而是共同安裝在一塊中介層上。

中介層是一塊超高密度布線的硅基基板(或高端有機(jī)基板),線寬/線距可達(dá)1μm級(jí)。

它的作用:

承載GPU和HBM; 提供超密互連橋梁,在毫米級(jí)距離內(nèi)連接數(shù)千I/O信號(hào); 保證信號(hào)完整性、低延遲、低功耗。

你可以把中介層想象成一塊“高架橋系統(tǒng)”,

GPU與HBM之間通過(guò)成千上萬(wàn)條“微型高速公路”直連,信號(hào)幾乎不繞路、不打彎。

五、HBM的演進(jìn):從1代到4代的“極限競(jìng)速”

代別 | 典型帶寬(每堆) | 數(shù)據(jù)速率 | 堆疊層數(shù) | 狀態(tài) |

HBM1 | ~128 GB/s | 1 Gbps | 4 | 已退役 |

HBM2 | ~256 GB/s | 2 Gbps | 8 | 主流 |

HBM2E | ~460 GB/s | 3.6 Gbps | 8 | AI訓(xùn)練主力 |

HBM3 | ~819 GB/s | 6.4 Gbps | 12 | 高端AI應(yīng)用 |

HBM3E | ~1225 GB/s | 9.2 Gbps | 12 | 2024-2025量產(chǎn) |

HBM4 | >1500 GB/s | >12 Gbps | 16(預(yù)期) | 研發(fā)中 |

未來(lái)的HBM4正在朝著更高層數(shù)、更寬位寬、芯片直接集成(3D-SoIC)方向演進(jìn)。

這意味著GPU與HBM的邊界將越來(lái)越模糊,甚至可能直接在硅片上“融合”。

六、技術(shù)挑戰(zhàn):HBM不是“堆上去就能跑”

HBM帶來(lái)的不僅是性能飛躍,也是一系列新的制造挑戰(zhàn):

TSV可靠性與應(yīng)力管理

TSV的機(jī)械應(yīng)力可能引發(fā)微裂紋,導(dǎo)致芯片翹曲或失效。

工藝需精確控制通孔蝕刻、填充、熱循環(huán)匹配。

熱管理

多層堆疊意味著熱量更集中。HBM堆棧內(nèi)部熱阻高,需要更高效的散熱通道與熱界面材料。

中介層制造復(fù)雜性與成本

硅中介層的布線精度極高,良率直接決定封裝成本。每增加一條信號(hào)線,成本幾乎線性上升。

測(cè)試與良率控制

多層堆疊帶來(lái)測(cè)試難度。任何一層失效都可能報(bào)廢整個(gè)堆棧,因此需要層級(jí)測(cè)試與Known Good Die (KGD) 策略。

七、總結(jié):HBM,是AI算力的“隱形地基”

HBM的本質(zhì)是——用三維堆疊和超密互連,把帶寬做成“面”而不是“線”。

它改變了內(nèi)存與計(jì)算芯片之間的關(guān)系,從“獨(dú)立模塊”變成“緊密耦合系統(tǒng)”。

AI GPU、超級(jí)計(jì)算、數(shù)據(jù)中心,乃至未來(lái)的Chiplet體系,都以HBM為帶寬支撐的核心。

一句話總結(jié):

GDDR讓GPU能跑,HBM讓GPU能“飛”。

它不是快一點(diǎn)的內(nèi)存,而是徹底重塑了“數(shù)據(jù)流動(dòng)的物理結(jié)構(gòu)”。

免責(zé)聲明:本文采摘自“老虎說(shuō)芯”,本文僅代表作者個(gè)人觀點(diǎn),不代表薩科微及行業(yè)觀點(diǎn),只為轉(zhuǎn)載與分享,支持保護(hù)知識(shí)產(chǎn)權(quán),轉(zhuǎn)載請(qǐng)注明原出處及作者,如有侵權(quán)請(qǐng)聯(lián)系我們刪除。

粵公網(wǎng)安備44030002007346號(hào)

粵公網(wǎng)安備44030002007346號(hào)